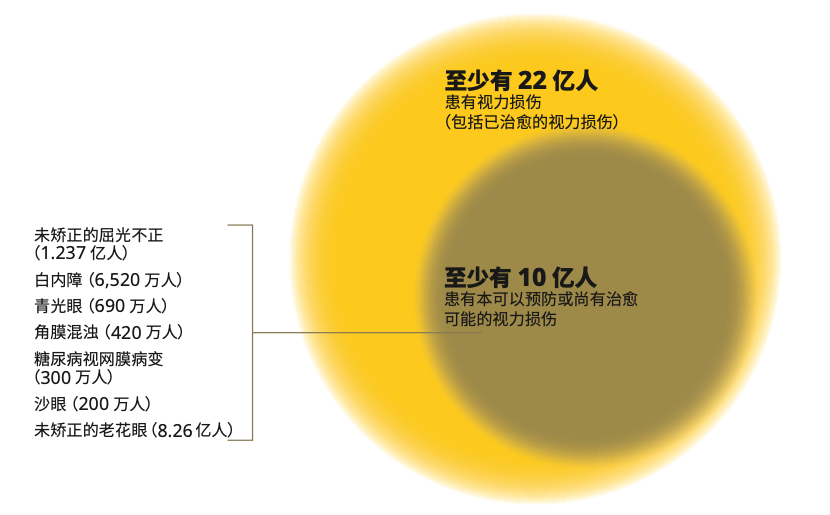

2019 年,世界衛生組織 (WHO) 發布了第一份「世界視力報告」。報告稱,全球至少有 22 億視力受損者,其中 2.85 億人為視障人群,3,900 萬人徹底失明。受全球人口增長和人口老齡化的影響,視障人群的數量在 2040 年可能會增長 3 倍。

全球視力受損者估計人數

視障者無法通過視覺系統接收外界的信息,在日常生活中面臨著諸多不便。他們很難躲避附近的障礙物,也無法從書籍或是屏幕中獲取信息。

但是針對視障人群的輔助設備卻存在成本高、維護困難、操作復雜等問題,很難滿足他們的生活需求。

為此,廣東技術師范大學和武漢科技大學的研究者基于智慧物聯網共同開發了一套視障輔助設備,通過 AI 算法和傳感器為視障人群的生活帶來便利。

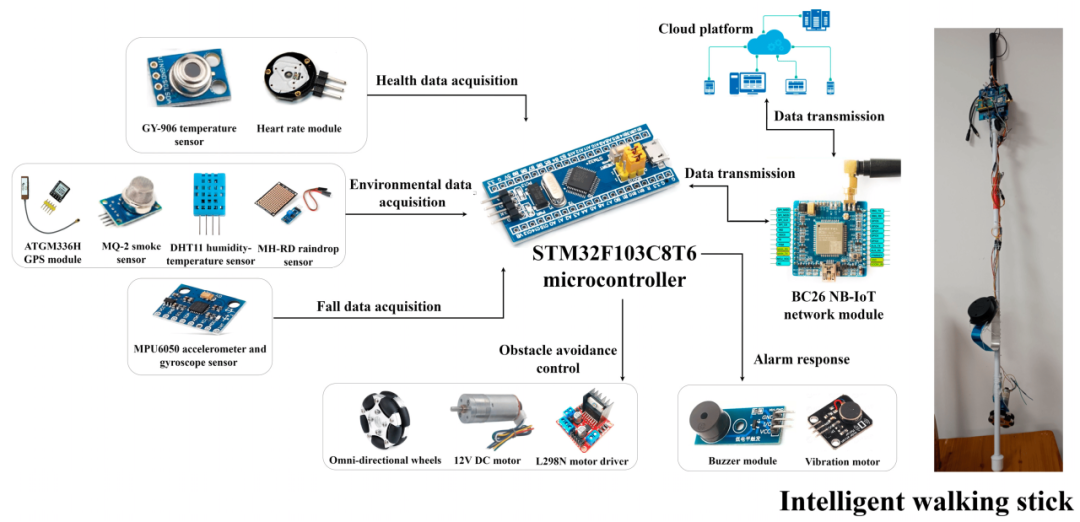

這套設備主要包括智能眼鏡和智能盲杖,總造價約 480 元。它可以通過多種傳感器監測使用者和環境的狀態,幫助使用者與環境進行交互并在危險狀況下發出警報。這一成果已發表于「Electronics」。

視障輔助設備應兼具便利和可靠性,以滿足視障人群的日常需要。為此,研究人員通過雙目相機收集圖像,隨后通過輕量級網格模型 YOLO v5 對物體及其距離進行分析,或是通過光學字符識別 (OCR) 閱讀文字。

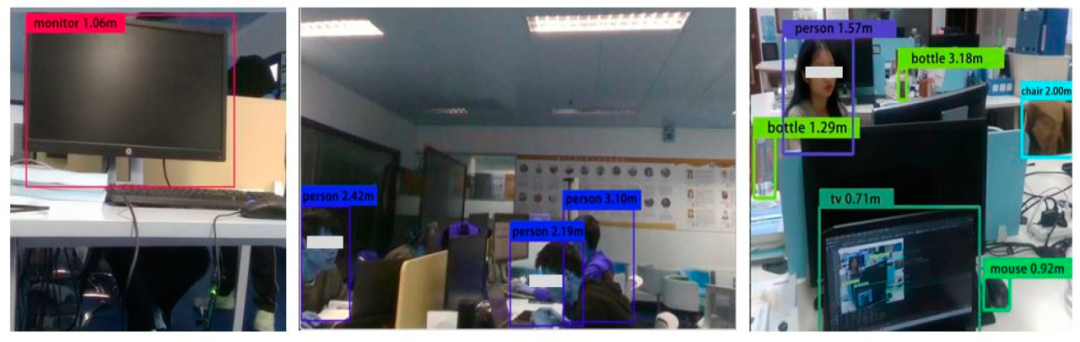

物體識別過程中,YOLO v5 算法會將圖片劃分為網格,隨后預測每個網格單元的邊界框,并在創建邊界框的同時識別出圖片中的不同物體。

除圖像識別外,YOLO v5 算法還能通過對比雙目相機的圖像計算用戶與障礙物之間的距離。

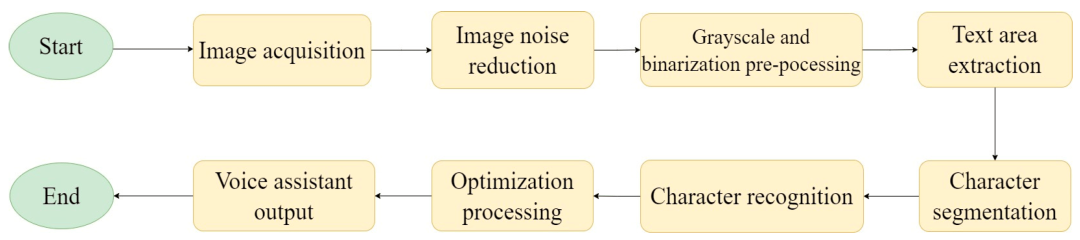

智能眼鏡的 OCR 功能通過調用百度 OCR 的 API 實現。OCR 過程包括圖像獲取、降噪、二值化 (Binarizatoin)、文字區域提取、字符分割、字符識別、優化及音頻輸出。

OCR過程示意圖

總結來說,就是智能眼鏡通過對圖片(指示牌)和其他障礙物進行一系列視覺處理后,最后通過語音傳輸到使用者耳朵里。

研究人員在常見室內外環境中對設備的物體識別能力進行了 20 次測試。結果顯示,室內外環境下 YOLO v5 算法均能比較準確地識別出環境中的物體,并對物體與使用者之間的距離作出判斷。

室內環境下的測試結果

室外環境下的測試結果

實驗中發現,隨著圖像中物體數量增加,錯誤率會隨之提高,尤其是對于具有相似特征的物體,比如電視與顯示器,或是自行車與摩托車等。最終,智能眼鏡的識別準確率為 92.16%。

但是即使 YOLO v5 算法認錯了物體,它依然能對距離作出判斷。與商用的 APP 相比,YOLO v5 算法判斷距離的偏離率在 0.28-6.32% 之間,隨著距離的增加而增加。

基于這一判斷,當使用者與物體之間的距離小于 0.7 m 時,智能盲杖會發出警報,同時接管微控制器以避開障礙物。

而智能盲杖的主要功能之一是健康監測,因此在盲杖上集成了心率、體溫等傳感器和數據收集模組。為實現非接觸測量,心率傳感器使用光體積變化描記圖法 (PPG, Photoplethysmography) 進行監測,體溫傳感器使用紅外輻射進行監測。

智能盲杖的結構示意圖

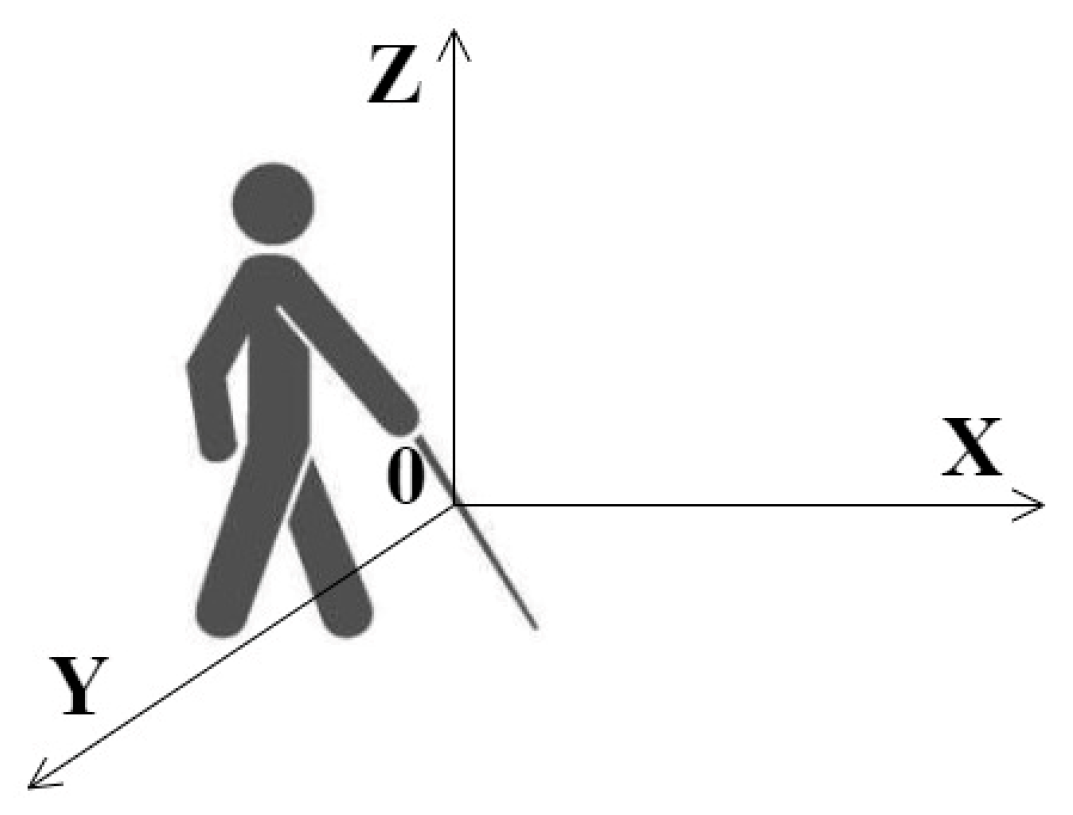

此外,為增強視障者對環境的感知,盲杖上還集成了溫度、濕度和姿勢傳感器。姿勢傳感器由加速度計和陀螺儀組成,通過計算使用者的組合加速度 (ACLR),監測其是否有跌倒的風險。

如果使用者距離障礙物過近,或是姿勢傳感器察覺到使用者可能會跌倒,盲杖將通過震動和蜂鳴器發出警報。(這里是通過智能眼鏡傳輸數據到盲杖觸發警報,盲杖本身未設置雷達)

這里值得一提的是,盲杖還設置了煙霧識別,對于有火險這樣的特殊使用場景是非常必要的。

用于跌倒監測的 3 維坐標系

其實,早在幾年前,就曾出現過類似的產品,名為Theia Vision,是一款智能眼鏡。

Theia Vision系統由一個可搭載在眼鏡腿上的相機和手機 APP 應用程序組成,可以把實況視頻轉換為音頻反饋讓佩戴者聽到,它可以幫助視障者認知周圍環境,是視障用戶的超級眼睛。

它可以接入到 AI 神經網絡實時進行物體檢測,從而為視障患者提供以下五種“超能力”:

物體檢測:尋找并識別鏡頭正對的物體并轉化成語音告訴佩戴者;

導航:通過提醒幫助佩戴者識別標志、交通信號、路牌和導航指示;

顏色檢測:幫助視障人士識別顏色;

貨幣識別:幫助佩戴者解決交易的問題;

文本轉語音:識別鏡頭內文本并轉化成音頻閱讀;

一直以來,由于群體小、設施成本高,視障人群的無障礙設施很難普及。盲道、盲文等便利視障人群的設施,則會因缺乏維護和管理,無法發揮效用。

不過,隨著經濟發展,科學技術的支持,已有相當多的個人和企業參與到了幫助視障人群的行動中。目前絕大多數主流手機品牌也已經有了專為視障人群設計的操作方式,視障人群也可以擁有自己的智能手機。

希望未來,能有更多的智能產品可以服務于需要幫助的特殊群體。

<code id="vvzuh"></code>